fastTextで文章分類(python)

文章を分類したくなったので、fastTextを用いて分類することにしました。

データ

今回は元々収集していたtweetデータを用いて分類していきます。今回私は、3つのカテゴリに分割しました。

ラベル1:人が呟いたもの

ラベル2:人が呟いたけれど何かのアプリケーション、botを介している?

ラベル3:企業が宣伝でtweet

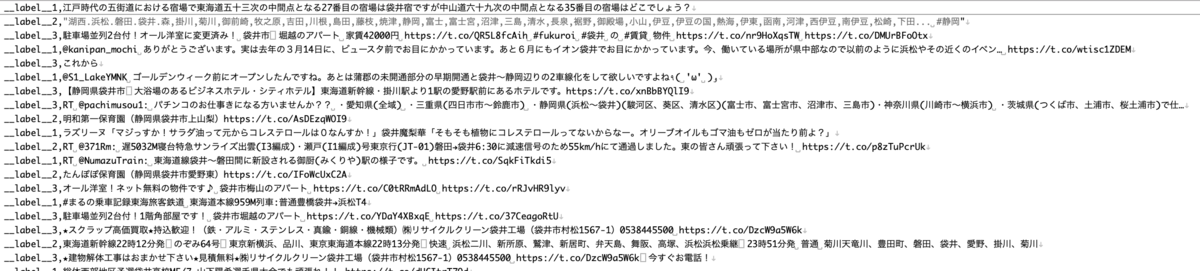

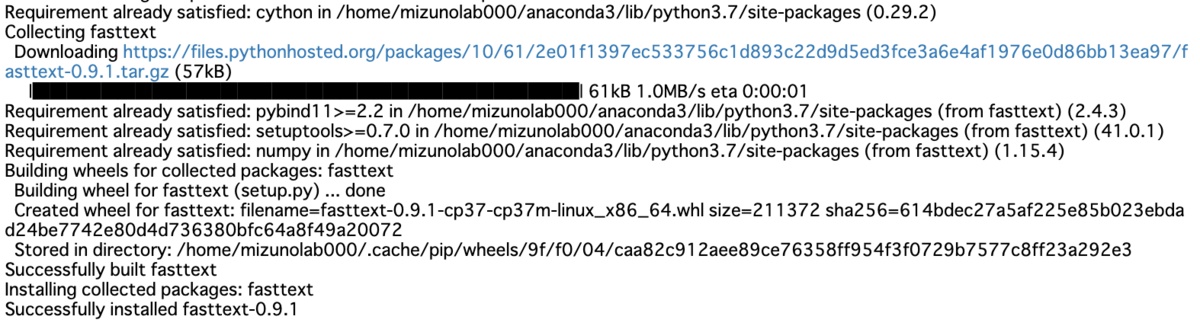

以下のようなcsvファイルを作成します。今回私が学習に利用するデータは全部で200件です。ファイル名はtrain_data.csvとします。

形式は以下のような感じです。

ラベル(__label__*),tweetの文章 *には数字が入ります。

__label__1,江戸時代の五街道における宿場で東海道五十三次の中間点となる27番目の宿場は袋井宿ですが中山道六十九次の中間点となる35番目の宿場はどこでしょう? __label__2,"湖西.浜松.磐田.袋井.森,掛川,菊川,御前崎,牧之原,吉田,川根,島田,藤枝,焼津,静岡,富士,富士宮,沼津,三島,清水,長泉,裾野,御殿場,小山,伊豆,伊豆の国,熱海,伊東,函南,河津,西伊豆,南伊豆,松崎,下田... #静岡" __label__3,駐車場並列2台付!オール洋室に変更済み! 袋井市 堀越のアパート 家賃42000円 https://t.co/QR5L8fcAih #fukuroi #袋井 の #賃貸 物件 https://t.co/nr9HoXqsTW https://t.co/DMUrBFoOtx

環境設定

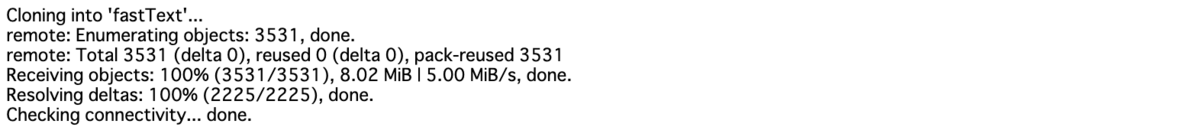

fastTextのインストール

git clone https://github.com/facebookresearch/fastText.git

cd fastText make

pip install cython pip install fasttext

文章分類プログラム(python)

学習用データ作成

学習用データの文章を分かち書きしていきます。流れはcsv読み込み→分かち書き→txt保存です。

csvデータを一気に読み込み、一文ずつ分かち書きを行い保存しています。

#csv読み込み→分かち書き→txt保存 import sys import MeCab import csv #csv読み込み csv_file = open("train_data.csv", "r", errors="", newline="" ) csv_data = csv.reader(csv_file, delimiter=",", doublequote=True, lineterminator="\r\n", quotechar='"', skipinitialspace=True) mecab = MeCab.Tagger ("-Owakati") #分かち書き設定 list_row = [] #分かち書き結果を保存 path_w = 'train_data.txt' #分かち書き済み学習用データ保存ファイル名 for row in csv_data: text = mecab.parse (row[1]) list_row.append((row[0]+' '+text).rstrip("\n")) f = open(path_w, 'w') for x in list_row: f.write(str(x) + "\n") f.close()

すると以下のようなtxtファイルが出力されます。わかりにくいですが、きちんと分かち書きされています。

__label__1 江戸 時代 の 五 街道 における 宿場 で 東海道 五 十 三 次 の 中間 点 と なる 27 番目 の 宿場 は 袋井 宿 です が 中山道 六 十 九 次 の 中間 点 と なる 35 番目 の 宿場 は どこ でしょ う ? __label__2 湖西 . 浜松 . 磐田 . 袋井 . 森 , 掛川 , 菊川 , 御前崎 , 牧之原 , 吉田 , 川根 , 島田 , 藤枝 , 焼津 , 静岡 , 富士 , 富士宮 , 沼津 , 三 島 , 清水 , 長泉 , 裾野 , 御殿場 , 小山 , 伊豆 , 伊豆 の 国 , 熱海 , 伊東 , 函南 , 河津 , 西伊豆 , 南伊豆 , 松崎 , 下田 ... # 静岡 __label__3 駐車 場 並列 2 台 付 ! オール 洋室 に 変更 済み ! 袋井 市 堀越 の アパート 家賃 42000 円 https :// t . co / QR 5 L 8 fcAih # fukuroi # 袋井 の # 賃貸 物件 https :// t . co / nr 9 HoXqsTW https :// t . co / DMUrBFoOtx

学習

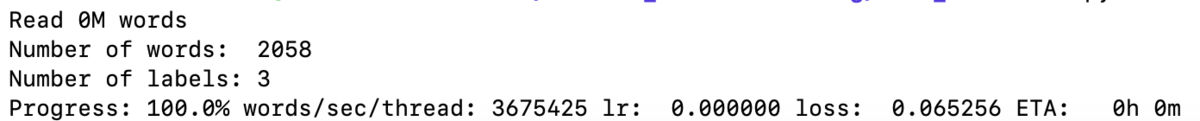

fastTextを用いて学習していきます。学習するには以下のコードを実行するだけです。学習回数(epoch, loss...)などは自分で最適だと思う値にしてください。

すると、model.binと言う名前のモデルが作成されます。

#fastTextで学習 import fasttext as ft model = ft.train_supervised("train_data.txt", label_prefix='__label__',epoch=1000, loss="hs") model.save_model("model.bin")

分類

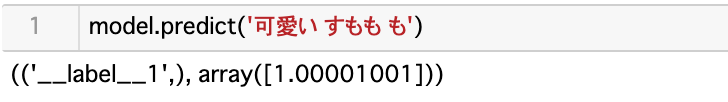

分類するには以下のコードを実行するだけ!

model.predict('*******ここに文章を入れます***** ')

例えば

もし、ラベル名と精度を出力したければ、以下のようにすれば良いです。

result = model.predict('フッピー 可愛い') print(result[0][0] + ':' + str(result[1][0]))

この時、result[0][0] にラベル、result[1][0]に精度が入っています。

参考資料

New release of python module · fastText

このブログを見てやろうと思った

機械学習で大量のテキストをカテゴリ別に分類してみよう! - WonderPlanet Tech Blog

そのほか

pythonでfasttextを使って文書分類してみた - Qiita

fasttextを用いた言語判定 - Out-of-the-box

fastextでテキスト分類したい - Qiita

csv読み込み書き込み

pythonでのcsvファイルの読み込み - Qiita

Pythonでファイルの読み込み、書き込み(作成・追記) | note.nkmk.me

pythonでlistをファイルに保存し、読み込む方法(numpyも同様!) - 技術メモ集